GLM-4.5

综合介绍

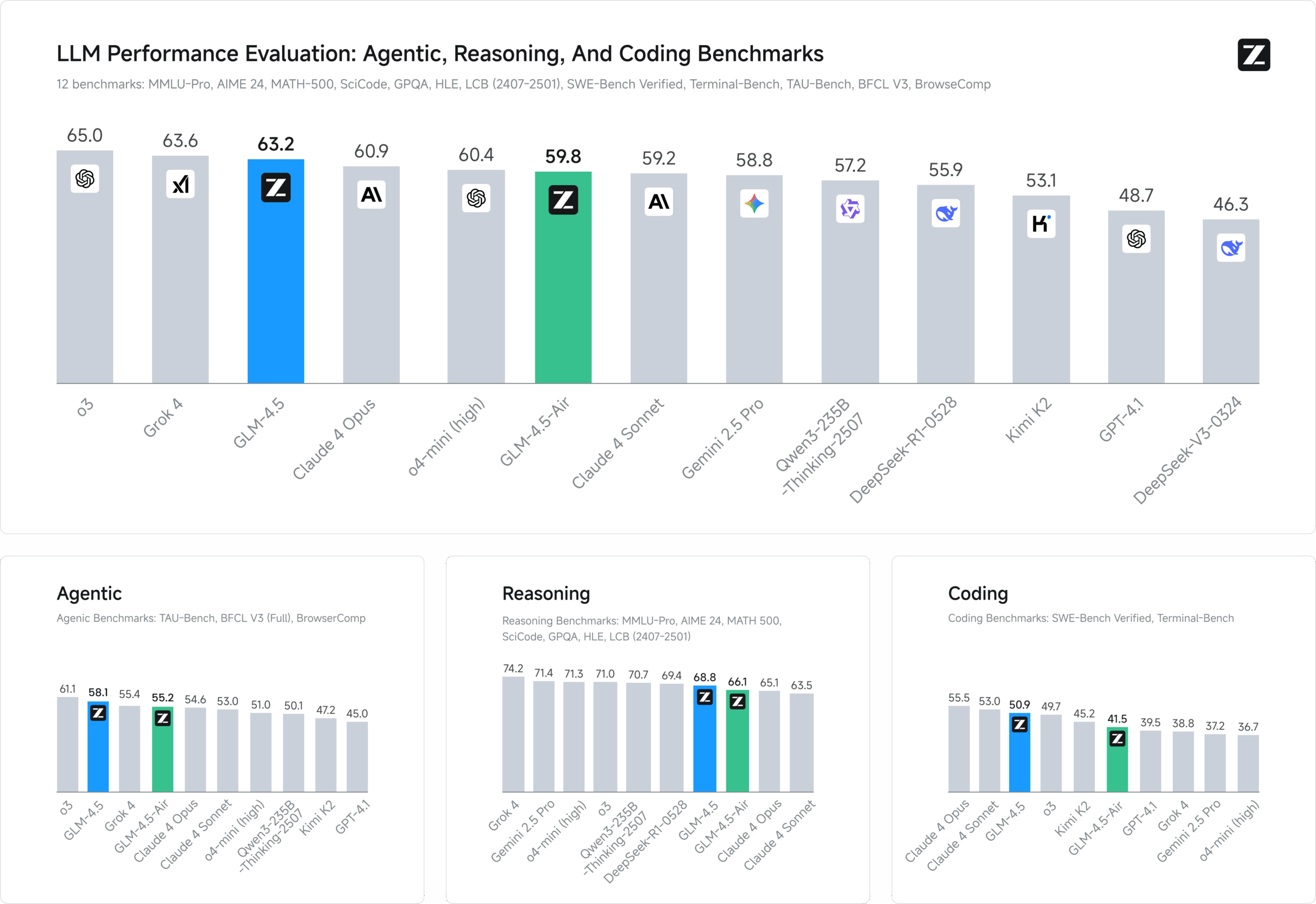

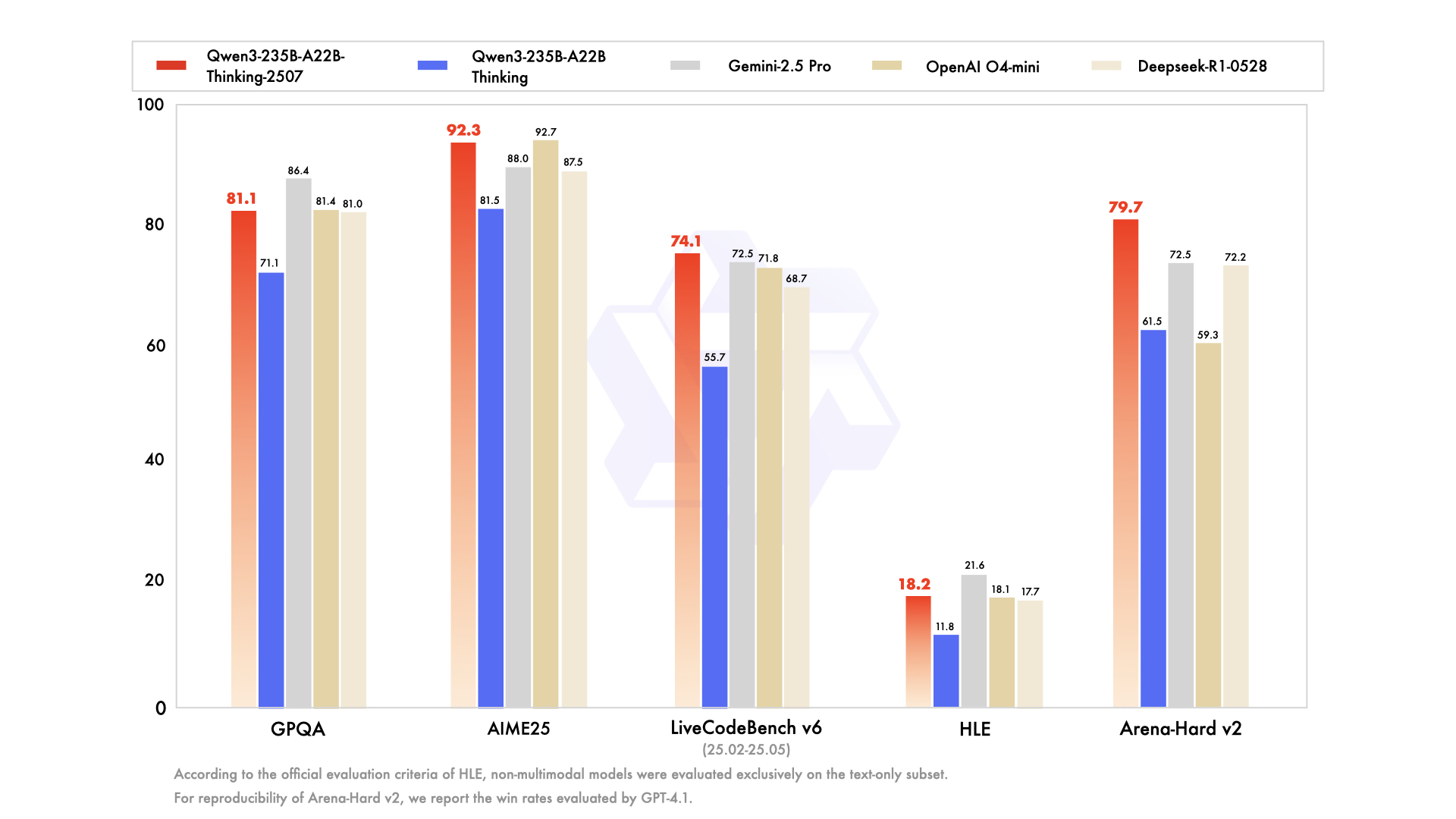

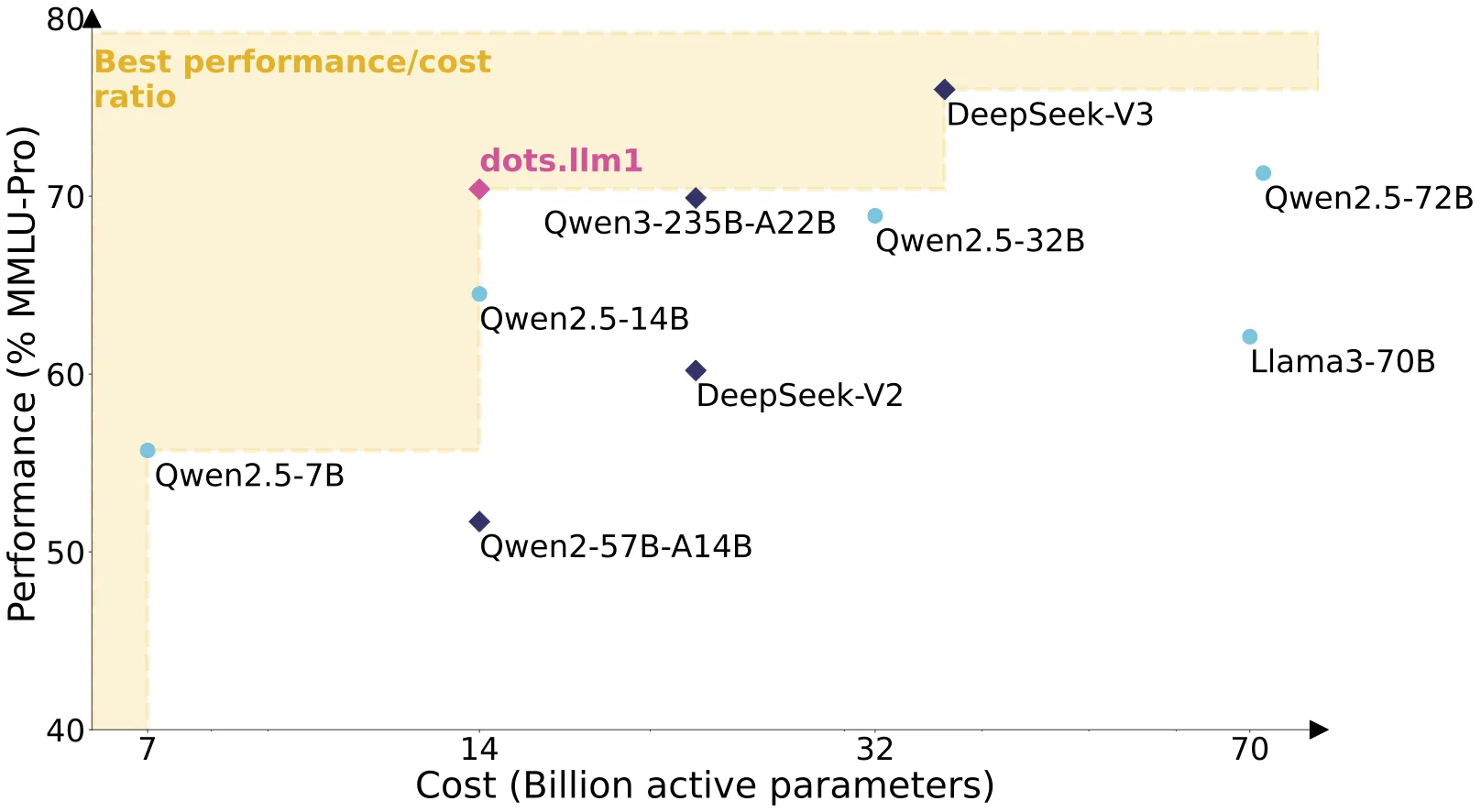

GLM-4.5 是由 Z.ai 公司(原智谱AI)推出的最新旗舰开源模型系列,专为日益复杂的智能体应用而设计。该模型最重要的技术突破,是首次在单个模型中原生融合了顶尖的推理、编码和智能体(Agent)能力。GLM-4.5系列基于混合专家(MoE)架构,在15万亿高质量令牌数据上完成预训练,拥有高达128K的上下文窗口和96K的最大输出Tokens。其旗舰模型 GLM-4.5 拥有3550亿总参数,在推理时仅激活320亿;轻量版 GLM-4.5-Air 则为1060亿总参数和120亿激活参数,实现了极高的参数效率。在多个权威评测基准的综合平均分中,GLM-4.5取得了全球模型第二、国产模型第一、开源模型第一的成绩。模型支持“深度思考”模式,可动态处理不同难度的任务,并通过 MIT 许可证完全开源,允许商业使用。

功能列表

- 统一能力架构: 首次在单个模型中原生集成了推理、代码生成和智能体三大核心能力,无需针对不同任务切换不同模型。

- 混合专家(MoE)架构: 采用高效的 MoE 设计,在庞大的总参数规模下保持较低的推理激活参数量,兼顾了性能与成本。

- 深度思考模式: 内置动态思考功能,可通过

thinking.type参数进行控制。模型可自动判断任务复杂度,对简单问题即时响应,对复杂问题则启动深度推理。 - 超长上下文窗口: 支持高达 128K Tokens 的上下文长度,可以处理和理解包含海量信息的文档或长对话。

- 强大的工具调用(Function Call): 具备行业领先的工具调用能力,尤其在可靠性和任务完成度上表现突出,能够稳定集成并调用多种外部工具。

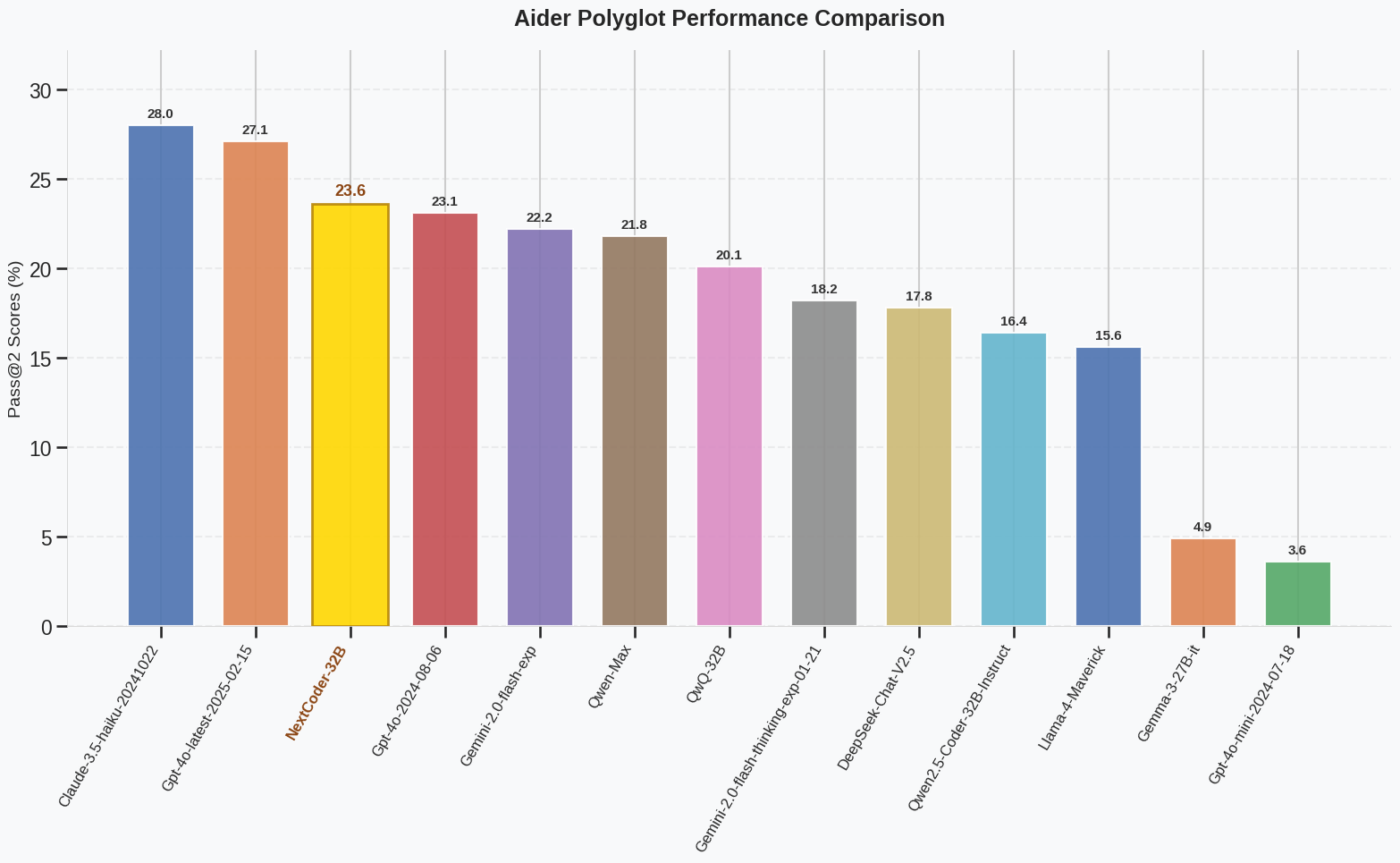

- 卓越的代码能力: 深度优化了软件工程、前端编程等能力,可用于智能代码生成、实时补全、自动化Bug修复,并能与 Claude Code 等智能体无缝集成。

- 结构化与流式输出: 支持以 JSON 等格式进行结构化输出,便于系统集成和自动化处理。同时支持流式输出,提升了交互体验。

- 开源且商用友好: 遵循 MIT 许可证,模型权重和代码完全开放,开发者可以免费用于商业项目,并在 Hugging Face 和 ModelScope 等平台获取。

使用帮助

开发者可以通过 Z.ai 官方平台或在本地私有化部署来使用 GLM-4.5 系列模型。

1. 官方平台API调用

这是最推荐和最便捷的使用方式,无需关心硬件部署,并且可以享受官方的性能优化和低成本。

准备工作首先,你需要在 Z.ai 开放平台获取你的 API Key。然后安装官方提供的 Python SDK:

pip install zai

Python 调用示例以下是一个完整的 API 调用示例,展示了如何启用深度思考模式和流式输出。

from zai import ZhipuAiClient

# 请填写你自己的 API Key

client = ZhipuAiClient(api_key="your-api-key")

response = client.chat.completions.create(

model="glm-4.5", # 或者使用 glm-4.5-air 等其他模型

messages=[

{"role": "user", "content": "作为一名营销专家,请为我的产品创作一个吸引人的口号"},

{"role": "assistant", "content": "当然,要创作一个吸引人的口号,请告诉我一些关于您产品的信息"},

{"role": "user", "content": "智谱AI开放平台"}

],

thinking={

"type": "enabled", # 启用深度思考模式。可选 'disabled' 关闭

},

stream=True, # 启用流式输出

max_tokens=4096, # 设置最大输出 tokens

temperature=0.7 # 控制输出的随机性,建议0.7

)

# 打印流式输出的结果

for chunk in response:

if chunk.choices[0].delta.content:

print(chunk.choices[0].delta.content, end='')

- 模型选择:

model参数可以替换为glm-4.5-air,glm-4.5-x等不同版本的模型。 - 深度思考:

thinking.type设置为enabled时,模型会根据问题难度自动决定是否启用更深层次的推理分析。对于简单问答,可以设置为disabled以获得最快响应。

2. 本地私有化部署

对于有数据隐私或特定定制需求的用户,可以在自己的服务器上部署开源的 GLM-4.5 模型。

环境要求

- 硬件: 运行 GLM-4.5 需要强大的GPU资源。例如,以FP8精度运行 GLM-4.5-Air 至少需要2张H100显卡;运行完整的 GLM-4.5 则需要8张H100显卡。

- 软件: 需要安装 PyTorch 以及

vLLM或SGLang等高性能推理框架。

部署步骤

- 克隆仓库: 从 GitHub 克隆官方仓库。

git clone https://github.com/zai-org/GLM-4.5.git cd GLM-4.5 - 安装依赖:

pip install -r requirements.txt - 启动推理服务 (以 vLLM 为例):使用

vLLM可以方便地启动一个与 OpenAI API 兼容的推理服务。# 使用8卡张量并行启动 GLM-4.5-Air 模型服务 vllm serve zai-org/GLM-4.5-Air \ --tensor-parallel-size 8 \ --tool-call-parser glm45 \ --reasoning-parser glm45 \ --enable-auto-tool-choice \ --served-model-name glm-4.5-air服务启动后,你就可以像调用官方 API 一样,将请求地址指向你的本地服务器进行交互。

3. 微调模型

官方推荐使用 Llama Factory 或 Swift 等框架对 GLM-4.5 进行微调,以适应特定的业务场景。例如,在4张H100显卡上即可对 GLM-4.5-Air 进行 LoRA 微调。

应用场景

- 智能代码与开发助手场景描述: 无论是从零开始搭建一个产品原型,还是在现有项目中修复一个复杂的Bug,GLM-4.5 都能提供强大的支持。它可以根据自然语言描述,生成包括前端、后端和数据库管理在内的全栈代码。在实际开发中,它还能作为智能体,自主调用调试工具、测试框架来验证代码,显著提升开发效率。例如,开发者可以在5分钟内生成一个完整的产品原型。

- AI 智能体与自动化任务场景描述: 利用其强大的工具调用和自主规划能力,可以构建复杂的 AI 智能体来自动执行多步任务。例如,可以创建一个“旅行规划智能体”,用户只需输入“帮我规划下周去北京的三日游,要求包含历史景点和美食探店”,智能体就会自动调用网络搜索工具查询景点信息、调用地图工具规划路线、调用餐厅预订工具,最终生成一份完整的行程表。

- 智慧办公与内容创作场景描述: GLM-4.5 可以作为强大的办公助手,自动完成报告撰写、数据分析和PPT制作等任务。用户只需给出一个主题或上传一份文档,模型就能自动提取要点、组织逻辑结构、搜索相关图片素材,并生成一份内容完整、视觉美观的演示文稿。这在办公自动化平台或AI写作工具中非常实用。

- 企业智能问答系统场景描述: 企业可以利用 GLM-4.5 及其长上下文能力,构建基于内部知识库的智能问答机器人。员工或客户可以就公司的规章制度、产品技术手册、财务条款等进行提问,模型能够精准地理解问题,并在海量文档中快速定位、整合信息,给出专业且准确的回答。

- 复杂文本处理与翻译场景描述: 面对法律合同、学术论文、政策文件等结构复杂、专业性强的长文本,GLM-4.5 能够进行深度的理解和分析。其翻译能力不仅支持多种语言,还能在翻译时保持原文的语境、风格和专业术语的准确性,非常适合出版社、跨国企业和学术研究机构。

QA

- GLM-4.5 系列包含哪些模型?它们有什么不同?GLM-4.5 是一个模型系列,主要包括:

GLM-4.5: 最强大的旗舰模型(355B参数),推理性能最强。GLM-4.5-Air: 高性价比的轻量级模型(106B参数),性能强劲且成本更低。GLM-4.5-X和GLM-4.5-AirX: 对应上述两个模型的高速版本,响应极快。GLM-4.5-Flash: 免费高效的多功能模型,适合快速迭代和测试。用户可以根据对性能、速度和成本的不同需求选择合适的模型。

- 什么是“深度思考”模式?应该如何使用?“深度思考”是 GLM-4.5 的核心功能之一,它允许模型根据任务难度动态调整其推理过程。通过 API 参数

thinking.type控制,enabled为开启,disabled为关闭,默认开启。- 简单任务: 如“北京的首都是哪里”,模型会直接给出答案,无需思考。

- 中等任务: 如“对比飞机和高铁去上海的优缺点”,模型会进行简单的分步处理和利弊分析。

- 困难任务: 如“根据这份财报预测下季度趋势”,模型会启动最大化的推理和规划能力,进行多步骤的深入分析。

- GLM-4.5 的 API 调用成本高吗?不高。得益于高效的 MoE 架构,GLM-4.5 系列在实现顶尖性能的同时,也极具成本效益。其 API 调用价格远低于主流模型,高速版本的生成速度实测超过 100 tokens/秒,兼顾了低成本和高效率,适合大规模商业部署。

- 我可以在自己的项目里免费使用 GLM-4.5 吗?可以。GLM-4.5 的模型权重和代码遵循 MIT 许可证,这是非常宽松的开源协议。这意味着任何个人或企业都可以免费地使用、修改、分发模型,并将其用于商业产品中,只需在产品中保留原始的版权和许可声明即可。